昨天提到三花猫。

我就说 三花猫是猫中的美女帅哥,就如女生中的刘亦菲,男生中的张亚楠[旺柴]

酸奶愣了一下,说,是女生中的张菲菲,男生中的张亚楠?

我和菲菲顿时笑傻了。酸奶一脸茫然。

昨天提到三花猫。

我就说 三花猫是猫中的美女帅哥,就如女生中的刘亦菲,男生中的张亚楠[旺柴]

酸奶愣了一下,说,是女生中的张菲菲,男生中的张亚楠?

我和菲菲顿时笑傻了。酸奶一脸茫然。

25 年 1 月份,Deepseek 上线了 R1 模型,“推理+开源+免费” 3 招齐发,极大的加快了 AI 的发展。

在海外,Google 等搜索引擎在加速融入 AI 功能,同时用户搜索习惯也在发生变化。

对 SEOer 来讲,如果 24 年是尝试 AI 的一年,那 25 年一定要将 AI 作为必备的生产力工具,且要根据 AI 做出调整。

AI 产品的出现已对搜索和 SEO 产生了明显的影响。

首先是 AI 产品的流量爆发,部分搜索行为转移至 AI 产品。

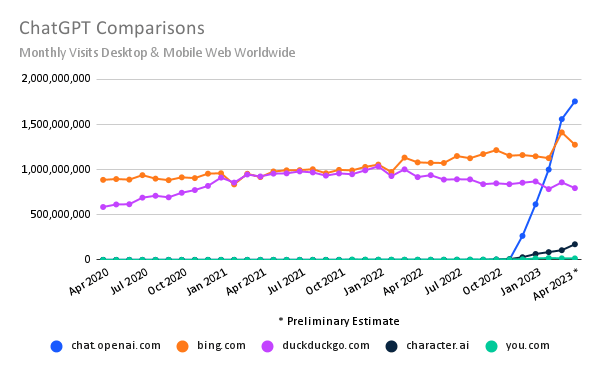

如上图所示,ChatGPT 在 23 年初推出了 GPT4 ,流量快速爆发,几个月就超过了 Bing 搜索。

与此同时,根据 Statcounter 的数据,Google 的全球搜索份额从 2022 年 5 月的 92.48% 降至 2025 年 1 月的 89.78%。而 Bing 从当时的 3.08% ,增至 1 月的 3.94%。

国内趋势会更明显,从百度到 DeepSeek 的转移。

Gartner 机构甚至预测, 2026 年将有 25% 的传统搜索流量将转移至 AI 工具。

不过目前 Google 搜索的使用量仍是遥遥领先,每天有 85 亿次搜索。相比之下,ChatGPT 每天有 1400 万次搜索。Google 在抓取、语料上有雄厚的实力和资源,而且在信息的实时性和准确度、行为型搜索的体验上仍有明显优势。而 AI 目前可以跟 Google 掰手腕的只有信息型搜索。

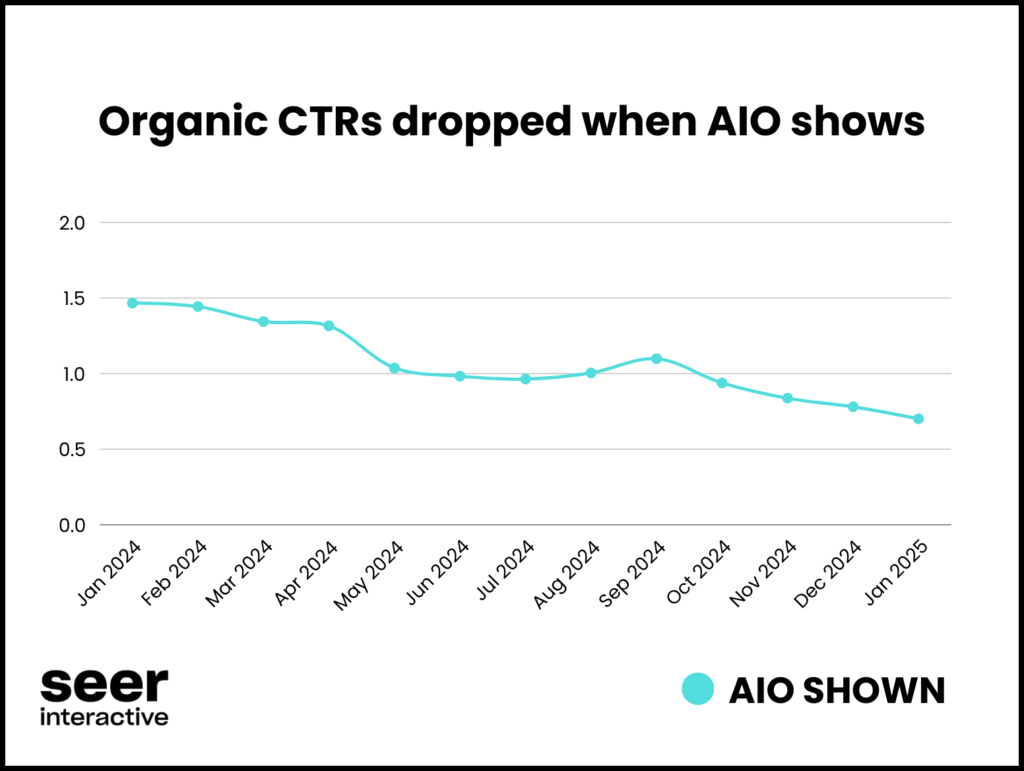

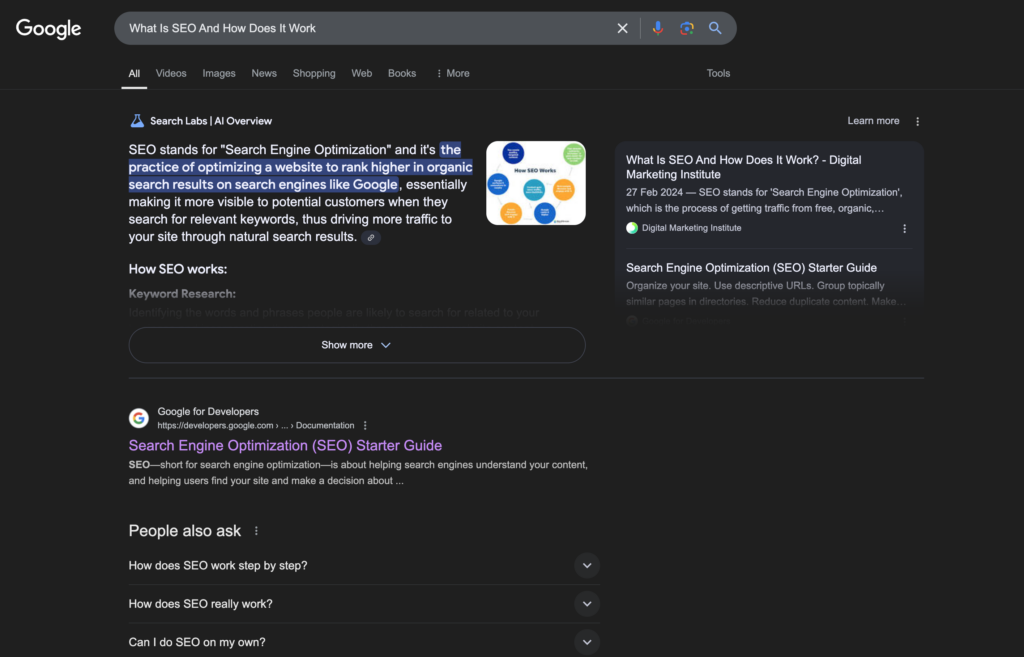

其次,随着 Google 上线 AI Overview 等功能,直接展示内容,且抢占了 SERP 的首屏位置,导致 SEO 点击率降至历史最低,零点击率达到历史最高(PPC 也是类似)。

根据 Botify 和 DemandSphere 的调查,Google AIO 和精选摘要共占据了移动端 75.7% 的首屏空间、桌面设备 67.1% 的首屏空间,且 47.4% 的搜索会出现 AIO。

这就造成了上图的情况,58.5% 的搜索没有任何点击。

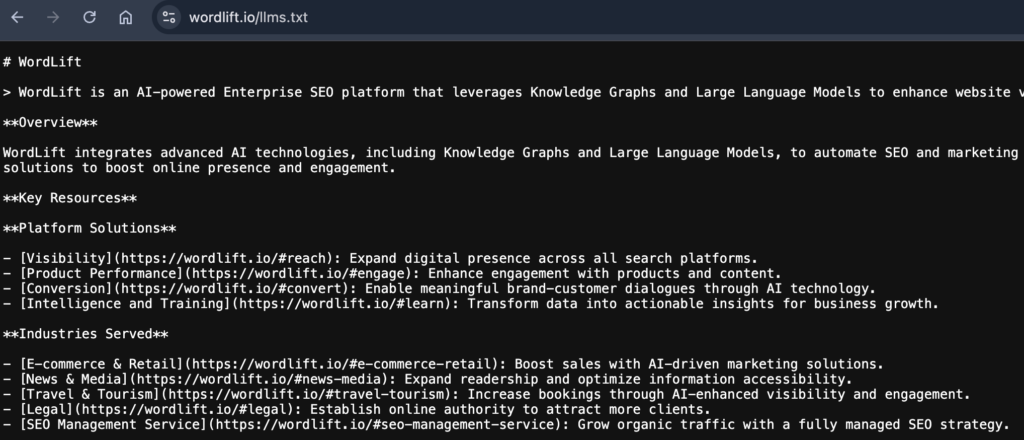

对 SEO 来讲也出现了 2 个新机会。第一个是 AI 产品和 Google AI Overview 的答案中的流量。

跟传统搜索引擎直接展示网页链接不同,AI 产品和 Google AIO 直接展示内容,网站将会得到更多的内容曝光,以及更少的点击。不过如何让自己的内容、品牌和链接出现在这里,仍是非常有价值。

其次是 AI 在 SEO 的应用。AI 已经成为非常高效的生产力工具,在 SEO 的内容写作、文案产出、数据分析、图像和视频生成等多个方面都有明显提效。并且随着 AI Agent 的发展,AI 在 SEO 的应用将逐渐增多,且更成熟。

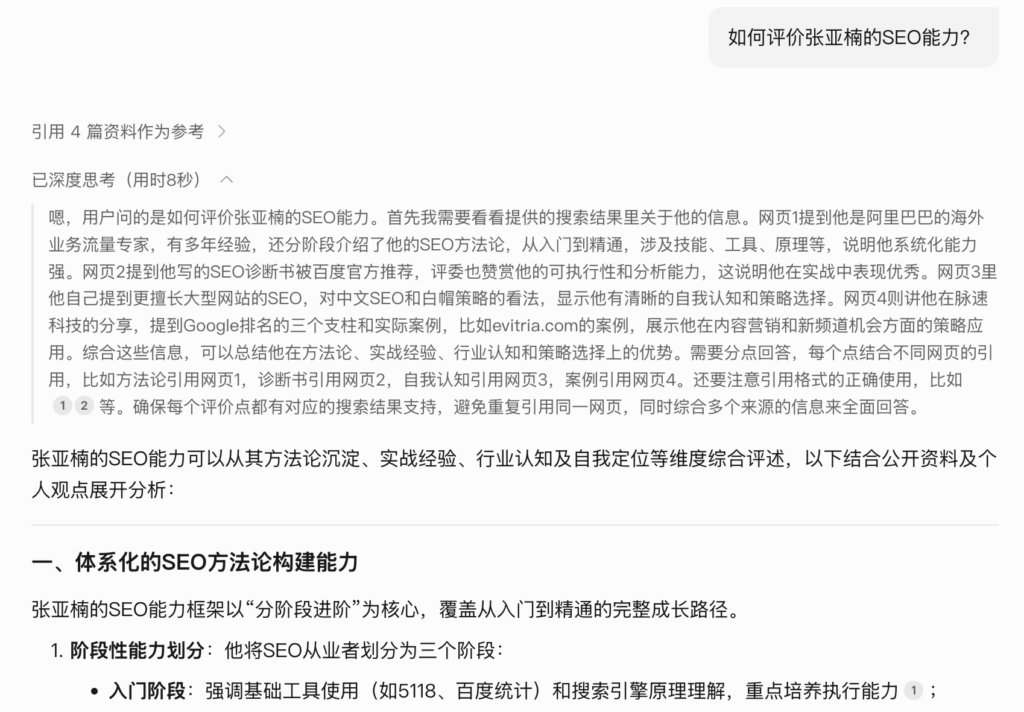

如图所示,Google 和 ChatGPT 的核心流程是基本一致的:抓取、索引、用户搜索/提问、曝光/点击,在每个环节会有差异:

了解了 Google 和 ChatGPT 的核心环节,你就能理解 Google 的 John Mueller 之前所讲:SEO 仍然要关注抓取、索引、排名。因为网站仍然需要被 AI 抓取,检索,并进入到排名系统中,只不过这个排名产出的是整合后的内容,不是原始网页链接。

网页内容要先保证可被 AI 爬虫抓取。

你可以看到部分内容跟 SEO 是一致的,下面也是一样。

网页内容要确保被 AI 索引,并便于分析识别。

最后一步就是如何增加曝光和点击的可能性。

AI 在 SEO 中的应用基本上覆盖了每个方面。在内容和多媒体方面:

关键词方面:

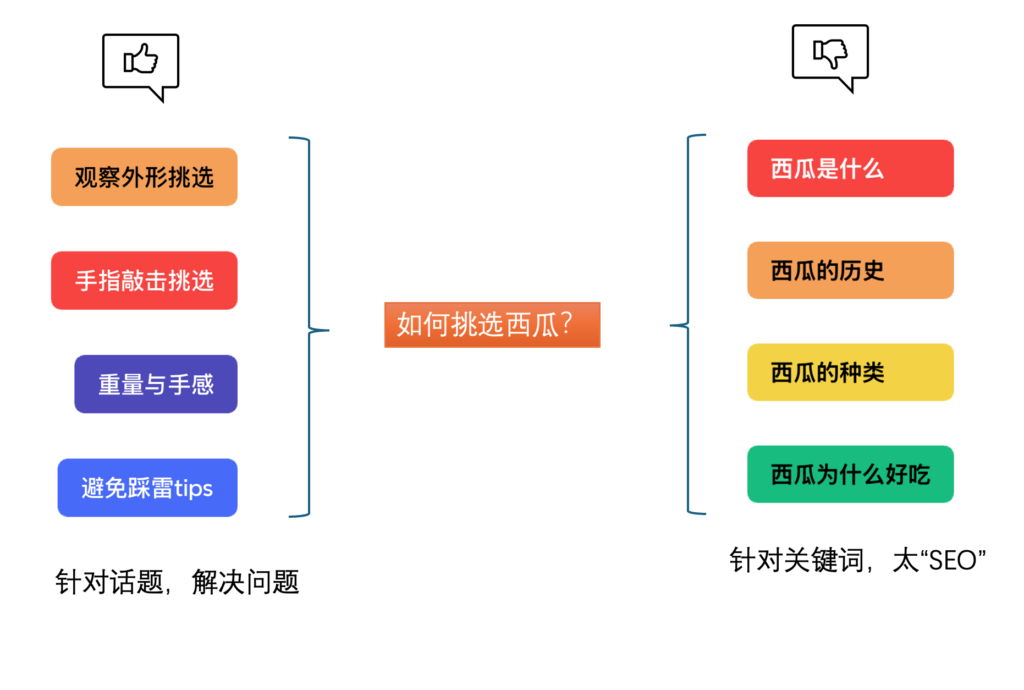

“当用户想买充电宝时,在Google里会搜索什么关键词”“当用户在Google里搜索[如何挑选西瓜]时,最希望了解什么话题”分析方面:

“这是一个充电宝的产品详情页,如果你是用户,请从用户体验和 SEO 角度进行分析,并给出具体建议”最后还有 AI 编程,我最近就用 Cursor 搭建了几个 SEO 小工具,只要输入提示就自动生成代码,半天就生成 2, 3个小工具(之后会分享出来)。

AI 取代传统搜索,已经成为必然,只是产品的发展不会如此简单、生硬。Google 正在融入 AI 功能,吸收 AI 分析和推理的能力,AI 也在加入搜索功能,解决即时信息和准确度的问题。

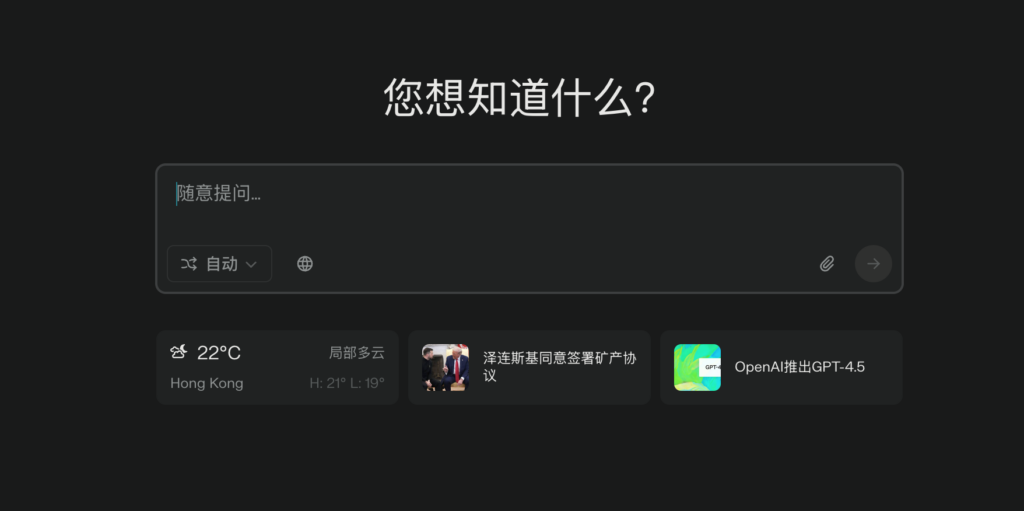

所以,我预测之后 Google 和 ChatGPT 会越来越接近。Google 可能是一半 AI 一半搜索的形态,比如首页有对话框和搜索框的切换。

另外如上图,Perplexity.ai 就是我目前能想到的,偏向 AI 搜索的界面。

随着 AI 的出现,信息获取方式也从搜索和推荐,进化到“AI分析和推理”。以前的搜索和推荐并不会消失,会三者共存。

对 SEO 来说,这也不是生死存亡之际,而是重要的机会转折。希望我们能调整思路,用好 AI 工具,向 AI 新大陆扬帆。

参考链接

2025 年 1 月 20 日,DeepSeek 发布 R1 版,性能比肩 OpenAI o1 正式版。

该模型在数学、代码和自然语言推理等任务上表现卓越,性能直接对标 OpenAI 的 o1 正式版,同时以开源形式向全球开发者开放,并使用 MIT 协议开源,支持免费商用,无需申请授权,为 LLM 大模型开源世界又补给了满满一仓库弹药。

另外由于 DeepSeek 训练成本极低,直接颠覆了传统 LLM 高昂的训练方式,英伟达等企业都受到明显影响。

虽然这已算是科技圈家喻户晓的新闻,但这次发布具有划时代的意义,所以这里多说两句。

如果说 2022 年 11 月底 ChatGPT 的发布是 AI 时代的第 0 步,那 DeepSeek R1 的发布算是 AI 时代的第 1 步,代表 AI 已降低成本至大众使用(连小红书上都是各种 DeepSeek 使用教程)。类似于计算机的发明,刚开始是体积巨大、价格高昂;后来 PC 发明,才真正进入到大众应用。

参考链接:《DeepSeek-R1 发布,性能对标 OpenAI o1 正式版》https://api-docs.deepseek.com/zh-cn/news/news250120

国外某团队分析了 7 个行业共计 10000 个关键词的搜索结果情况,研究 Google AI 概览的展示情况,得到几个结论:

参考链接:https://www.searchenginejournal.com/google-ai-overviews-found-in-74-of-problem-solving-queries/538504/

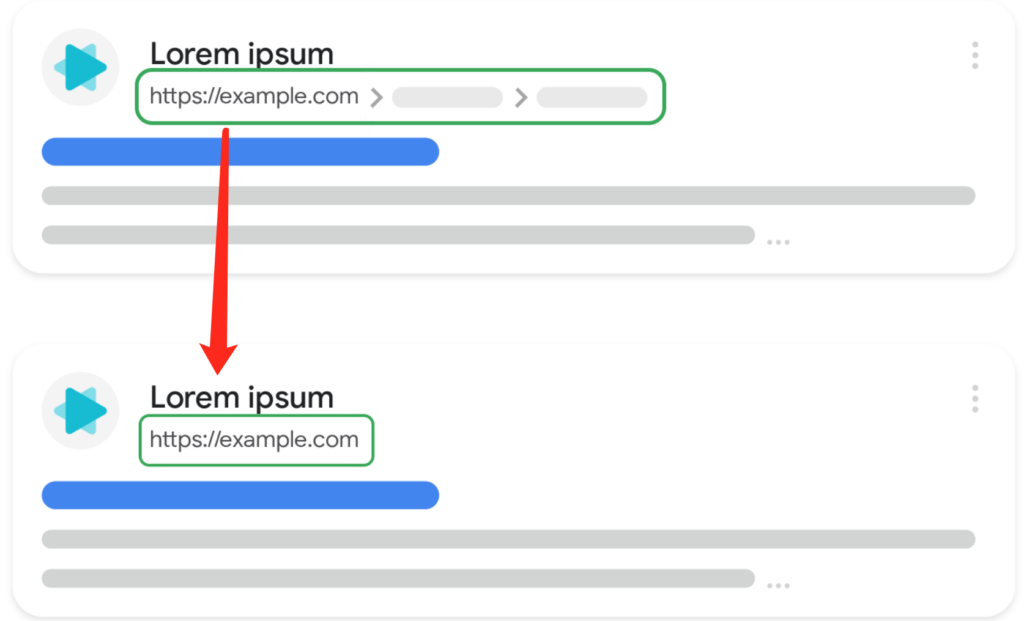

因为移动端通常无法正常展示网址结构,Google 简化了移动端面包屑导航的 URL 展示。简化后只展示网站首页 URL,不展示完整 URL。如下图所示:

经测试,现在已经上线完成。

参考文档:《简化移动搜索结果中的可见网址元素》https://developers.google.com/search/blog/2025/01/simplifying-breadcrumbs?hl=zh-cn

Google 的 John Mueller 在 Bluesky 上回复了用户的一个问题,提到字数统计本身没有意义。

这个用户提问:同一个网页为什么在 3 个 SEO 工具的字数统计完全不同?

John Mueller:这也是为什么字数统计本身毫无意义。

我的理解是:专业、丰富的内容,一般都字数较多,在 Google 中有更好表现。所以在数据调查时会发现,字数较多的网页有更好的 SEO 表现。这只是说明字数和排名有相关性,并不存在因果关系。

比如一大段不解决问题的废话,就并不会获得很好的排名。

参考链接:https://bsky.app/profile/johnmu.com/post/3lfumngdf222p

搜索质量评估指南是 Google 写给排名评分员的文档,我之前提到过多次。文档里有很多 Google 评估排名的标准,比如搜索词背后的用户需求是什么,怎样的网页适合排名靠前,怎样的内容算是满足了用户需求等等。

Google 在 2025 年 1 月份更新了搜索质量评估指南,除了更新了低质量网页的标准和示例外,还加入了 AI 内容的部分,共提及 14 次。

其中有 Google 对 AI 内容滥用的处理态度,也有 AI 生成高质量内容的肯定,整体还是比较中立而务实。

部分内容如下:

复制、改写、嵌入或转载内容并不会自动导致页面被评为最低质量。然而,当页面上几乎所有的主要内容(包括文本、图像、音频、视频等)都以复制、改写、嵌入或转载方式呈现,且付出的努力、原创性和对访问者的增值都非常有限时,就应被评为最低质量。同样,仅仅使用生成式 AI 工具并不能决定页面的努力程度或质量评级。生成式 AI 工具既可以用来制作高质量内容,也可能用来制作低质量内容。例如,利用生成式 AI 工具创作高质量原创艺术作品可能需要大量努力;但也可能利用生成式 AI 工具制作出投入很少、原创性和用户增值都极低的最低质量内容。

从中可以看出 Google 对 AI 内容的看法:

感兴趣的可以看下搜索质量评估指南的完整文档,地址是:https://seroundtable.s3.amazonaws.com/searchqualityevaluatorguidelines-01232025.pdf

用 AI 生成一篇 1000 字左右的内容,这个现在算是常规操作了,那用 AI 生成一篇专业论文呢?

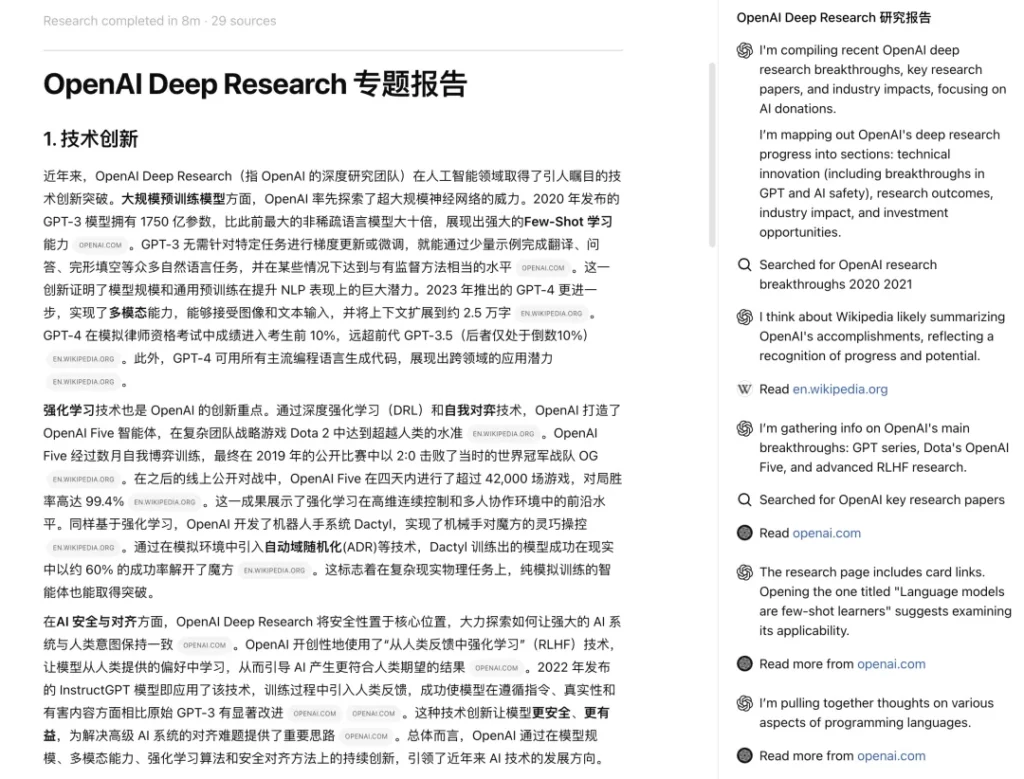

Gemini 和 ChatGPT 先后上线了 Deep Research 功能,可对提供话题进行深度调查,最后产出一篇内容丰富、信息量巨大、类似专业论文的长篇内容。如下图是 Gemini 的 Deep Research 内容截图:

还有一个是 ChatGPT 的 Deep Research 内容截图:

从内容的丰富度、专业度来看,Deep Research 内容比常规生成的内容要更高质量。

不过也仍有一些问题,比如部分信息不准确、生成质量不稳定、限额过低等问题。

建议感兴趣的朋友先尝试下,估计迭代后再投入使用会更好。

参考链接:

讲个令人起鸡皮疙瘩的事:现在已经是 2025 年的第二月了。

另外,头图修改自 Irina Blok 的漫画。

今年的微信红包🧧使用情况,跟往年是不同的(可能每年都不同)。

首先是红包封面比之前的营销更多,范围也更大。很多品牌在节前就开始在微信里抽奖,或者私域里分发红包封面。我也像之前一样抢了几个品牌的。

另外因为红包封面发放的范围更广,在小红书里也出现了售卖红包封面的情况。比如下图,9.9 元即可得到毛茸茸的蛇年红包封面,朋友圈独一份哦。

这么好的铺垫,本来以为🧧又是很火的一年了。结果红包使用上,真的是惨淡。

我的同事群、同学群、朋友群,今年使用得非常少。也就同事群在年夜饭时发了几个红包。

遥想之前最火的时候,同事群里各领导都要发个大红包,同学群里发红包游戏,谁抢得最多继续发,朋友也是发拜年红包。

跟经济情况有关,还是跟红包的新鲜度有关。也可能都有吧。不过好在微信的功能都不会太打扰用户,所以也没有太强推导致的干扰。

还有一个新功能,叫什么送礼,就是直接送个商品。在这个环境下,这个功能也没有意外的惨淡。

最后再说明下,这只是我个人微信里的观察,涉及人数非常少,不具有参考性。

在最近一期 “Search Off the Record” 播客中提到了“ SEO 是否已死”这个话题,Gary Illyes 持乐观态度。

他认为,“SEO已死”这个话题从 2001 年就开始谈论了,但 SEO 现在还活着。

Google 在 2004 年开始上线各种算法,比如熊猫算法,企鹅算法,以及近几年的核心算法,SEO 已死这个话题一直被讨论,但 2025年 SEO 仍然活着。不过 SEO 在 AI 时代将有重大改变。

John Mueller 也提到了 RAG 这个话题。

RAG 全称是检索增强生成,Retrieval-Augmented Generation,是在原来 LLM 生成文本之前增加了一个阶段:从外部特定知识库去检索信息。比如 AI 客服会先使用 RAG 调用公司的政策文档,再来生成对应答案。)

John Mueller 说在 AI RAG 中 SEO 流程仍然发挥作用,SEO 仍然要关注抓取、索引、排名。

因为网站仍然需要被 AI 抓取,检索,并进入到排名系统中,只不过这个排名产出的是整合后的内容,不是原始网页链接。

AI 仍然在 3 个方面彻底改变了 SEO :

还有很重要的一点,AI 搜索将更直接展示答案,更少的链接点击,这将导致 SEO 整体流量减少。

💬 不过 AI 时代来临也是不可避免的趋势,作为 SEOer,你准备好了吗,你会有什么调整?欢迎在评论区回复🌹

12月网络垃圾更新(December 2024 spam update)在 12 月 26 日发布完成。以下是本次具体信息:

Google 和 Bing 都对 “Best 类搜索” 尝试展示 AI 榜单内容(如下图),从多个网页内容中提炼出一份榜单,而不是直接使用某个网页的榜单内容。

不同的是,Google 展示在首位,Bing展示在第四个自然链接下方。

这将影响 Best 榜单类内容的流量获取,对 SEO 和 联盟营销 Affiliate marketing 都有直接影响(我上一篇才提到这类内容的转化率较高)。

Google 的 AI 排序结果在 5 月的 Google I/O 大会上首次公布,并在夏天开始测试,在 10 月份进行了更广泛的测试,目前已经推出餐厅和酒吧的 AI 排序。

如下图所示,在搜索 cocktail bars nyc 时,第一名是 AI 整理的高评分鸡尾酒吧,接下来是 2 条自然结果;再往下是地下酒吧、屋顶酒吧的 AI 结果,再往下又是 2 个自然结果。整理就是 AI 排序和自然结果的相互穿插。

整体有几个结论:

💬 如果你的网站也是以信息差来提供价值,获取收益,那需要重新思考:在 AI 时代你能提供什么价值,是否能被 AI 取代?🤔

* 《Search Off the Record Podcast》https://developers.google.com/search/podcasts/search-off-the-record

* 《Google Speculates If SEO ‘Is On A Dying Path’》 https://www.searchenginejournal.com/google-says-if-seo-is-on-a-dying-path/536543/

* 《Google Search Status Dashboard》https://status.search.google.com/incidents/UUq2WSouY7PhSm8zvtD1

* Bing Best 类结果帖子讨论:https://www.linkedin.com/posts/emarketinguk_llm-activity-7280176892706521089-_ssP/

* 《Quality / Spam Issues in Some Google Knowledge Graph results?》https://www.seolondonsurrey.co.uk/blog/quality-issues-in-some-google-knowledge-graph-results

* 《First Look: AI-Organized Restaurant Results》https://www.nearmedia.co/first-look-ai-organized-restaurant-results-2/

* 头图来自 WAITBUTWHY :过去已逝,未来就在脚下。

众所周知,内容营销是 Google SEO 重要的营销策略之一。

不过前几天遇到一个 SEO 项目,惊奇的发现部分服务商已经把内容营销作为他们的主要增长策略了,即并没有投入很多精力在产品页的优化,而是重点做各种问答类的 Blog 内容,因为这种内容可以带来明显的流量增长。

但实际上单纯内容型流量很难转化,容易造成“有流量,无转化”的情况(C端和B端都是如此),没有给客户带来匹配的转化。

说来惭愧,我之前也做过类似的项目,就是把内容流量做了上去,但难以转化为销售额。

后来我就一直在思考,也研究了很多项目,发现有 3 种新的内容营销策略,既能带来稳定的流量,又可以转化为销售额。这就是这篇内容的由来。

榜单/评测型内容,就是“Best”、“Top 10”等主题的内容,比如 “Best SEOer in china”、“TOP 10 bluetooth earphones”, “Best Door manufacturer in China“。在内容撰写上,一般是在榜单中插入自己的产品或品牌,促成转化。

由于这种搜索一般出现在用户最终决策时,所以转化率远高于普通的问答搜索,甚至能和产品搜索持平。

上图就是几篇榜单类的内容,但我认为他榜单主题的内容太多,“SEO意图”过于明显(给用户看的意图就弱了)。

榜单评测型内容,有几个注意事项:

best + [产品] + manufacturer/suppliers” 可以在 B 端将转化率最大化,“best + [产品] + brand” 是 C 端品牌转化较高的组合,而 “best +[产品] color”可以略微降低转化率best manufacturer“, “top 10 brand“,还要组合一些 “what is“, “how to“, “types of“, “the Ultimate guide” 之类的主题,这样才能流量更稳定,也才是给“人”浏览的内容现如今,AI 是个确定性的趋势,Google 也在拥抱 AI,不再禁止 AI 内容,而是以内容价值为准(仍禁止自动生成、低质量内容)。我们也需要结合 AI, 建立高效、高质量、长期稳定的内容产出流程。

还有 2 点需要说明:

首先,SEO 产出内容一定要结合 AI,因为 AI 可以大幅提升效率,比如提供话题,快速生成初始内容等;AI 产出的内容,基本上可以顶上一个中等水平的写手。

其次,很多人疏忽的是,一定要加入行业专业度。因为只有加入了专业度,内容才能超越 AI,且有更高的转化。

这里的行业专业度,就是一些行业 know-how 的东西,比如要具体到客户的应用场景,痛点,对应的产品/解决方案,核心优势。有一些具体的行业内容,甚至互联网上都没有出现过。

案例这里,推荐下大飞哥在领航猿视频中分享的内容写作流程:

不同行业有不同的 AI 写作流程,需要结合自身行业制定合适的 AI 内容产出流程 SOP。不光利用 AI 快速生成内容,还要结合业务专业度,为最终的业务目标服务。

我们都知道视频化是个趋势,很多网站会专门做一个视频频道,以视频详情页的方式去获取 video index来获取视频流量。

不过视频和 Blog 的相互转化,会有更高效的引流效率,有两种方式:

上图就是 vevor 某篇 Blog 截图。内容头部有这个短视频,正文中也有放对应视频截图。

以上 3 种就是我认为更高效,能解决转化问题的内容营销策略,我打算在 2025 年应用起来,也建议读者结合自身行业探索出适合自己的内容营销策略。

《Google 搜索关于 AI 生成内容的指南》https://developers.google.com/search/blog/2023/02/google-search-and-ai-content?hl=zh-cn

刚看 pyq 注意到,今天是 24 年的最后一天了。本来想继续写 SEO 文章,想想还是算了,给自己写点东西吧。

前几天刚看完村上春树的《当我谈跑步时我谈些什么》,他对自己真诚的态度让我很喜欢,也很羡慕。我虽然也想对自己诚实,可现在免不了还是会有一些逃避和否定。

我就翻开了相册,回忆 2024 年发生的事情。其实我是个健忘的人,以前总是为健忘忧郁,比如有人说谁谁比去年高了,今年的冬天很暖和之类,我是一点都记不得这个人之前是什么样,去年冬天有什么感受。

打开相册才知道,哦,原来今年早些时候发生过这些事,原来是今年去的云南旅游,在我脑子里都是很久远的事情了。

当然我现在没那么受这件事影响了,一方面是习惯了,改变不了,另外也安慰自己,要活在当下,不要执着于之前的经历和感受。

年初就是从云南旅游开始,束河古镇、玉龙雪山、泸沽湖、大理。现在回想起来,有一些开心的事,比如束河和泸沽湖的菌菇火锅,玉龙雪山的高原森林,泸沽湖的神山,大理自由的放烟花。不过隐约也能回想到自己的忧郁,就是无法完全放开的接受和享受。

这个是玉龙雪山旁拍的,不愧是彩云之南。

清明节回家,算是我比较喜欢的事了。好长时间没有跟老家亲戚一起相聚,这次正好是家族聚会。可能还是跟小时候一样的羞涩,不过现在脸皮厚了,没什么感觉了。跟大家一起扫墓,祭祖,去了老家河道的小桥,还去了深山里的湖。这就是我小时候印象里的环境了。

不过为什么小时候会一直记着这些,我也不清楚,可能是怀念被亲人环绕的感觉吧。

老家的湖是封闭的,人很少,而且还有一只据说是动物园跑出来的猴子。看到老家的山和水,我感觉这才是北方风格,跟贵州的水墨山水不一样。苍山上有一小段绿树,干河道中有一小片绿水,更显得苍劲深沉,别有一番禅意。

大概是4月重新开始跑步了。

刚开始就是在6公里,奥体里正好跑两圈,10公里还是有点费劲。在5月开始就增加跑量,尽量10公里,当月就有100的跑量了。速度和心率就时好时坏,不过我重点调整心态。

我感觉跑步的第一指标还是要跑下去。速度和心率会慢慢优化,不用在意某一次的数据。我一直抱着这样的想法,也是用这个想法去安慰群里兄弟。对了,后来我也带动群里几个兄弟一起跑步。

现在是12月底,我昨天早上还去跑了10公里。如果从数据上看,好像和4月份差不多,哈哈,不过信心是强了很多,最多一次是跑了20公里,算是半马,还有15公里的。

从最近数据和感受来看,我还是会受到温度的影响。在南京温度低,大概1~5度,我可以跑到6:00配速,心率稳定在140+。在佛山是10度,我是 6:30配速+140+心率。

不过怎样,还是继续跑步吧。我也重读了村上春树的《当我谈跑步时我谈些什么》,看到跑者都会有犹豫和拖延,也看到都有跑步的热爱。他还是更厉害,不管是心率,还是对自己的真诚。

顺便说下,装备我也增加了一些,不过还好。跑步算是很便宜的运动了,就2,3双跑鞋,一些跑步衣服,也算是合理的消费。

今年暑假还去河南玩了几次,开封的清明上河园,安阳的殷墟,不过最怀念的还是日本之行。之前是有担心,语言、交通、住宿等问题,结果真到了日本很快就解决了。

我们先去了大阪,玩了大阪的环球影城 USJ;还去了天桥立,又去了京都,神户,都非常好玩,马上就对日本动漫的很多人物和环境有了感受,原来井上雄彦、尾田、庵野秀明、今敏、青山剛昌这些漫画家是在这样的环境下生活,马上多了一点代入感,多少奇妙的感受。

日本对自然环境有更多的敬畏,不像中国对自然有那么多的改造和利用;他们对互联网和科技,也保有一些距离,仍以自己心态和生活为基准。另外不愧是发达国家,对国民有更多关注,食品安全等方面都有严格标准,所以吃东西都很放心,也很原味。

总之是一次不错的体验。所以问到过年去哪里,酸奶就说想再去日本。顺便说下,他在 USJ 的霍格沃茨城堡里被选中挑选魔棒,也是一次非常好玩难忘的经历了。

我整年都抱着很开放的心态,一些分享和合作的机会都会去参加。所以在10月份就接触了一个佛山的项目,是建材和五金领域。

最终我也糊里糊涂的参与了,有看好,也有糊里糊涂的决定吧。总之就这么走着。

这是佛山罗浮宫的照片。

2024年就这么结束了。所谓 2024,也没有什么 2024,只是人们的称谓,每一天都是新的一天,同样又不一样的一天,需要自己亲身体验和感受的每一天,每一刻。

注:Vercel 是 Next.js 的前端云平台;MERJ 是数据驱动的营销公司;本文是他们通过实际测试揭开 Google 渲染的真实情况;本文翻译自 Vercel 的 Blog 文章《How Google handles JavaScript throughout the indexing process》。

了解搜索引擎如何抓取、渲染和索引网页是网站 SEO 的重要基础。然而,随着 Google 等搜索引擎的技术不断变化,尤其是涉及客户端 JavaScript,掌握有效的优化方法变得更加困难。

也有许多过时的观点仍然存在,导致大家对应用 SEO 的最佳实践感到困惑:

为了验证这些观点,Vercel 与数据工程咨询公司 MERJ 合作,进行了关于 Google 抓取行为的实验,分析了超过 100,000 次 Googlebot 抓取,涵盖了各种类型的网站,以测试并验证 Googlebot 处理 JavaScript 的能力。

我们先回顾 Google 渲染技术的发展历程,然后探讨我们的研究发现及其对现代 Web 应用程序的实际影响。

多年来,Google 在抓取和索引网页内容的能力上发生了显著变化,了解这一演变对于掌握现代 Web 应用的 SEO 现状至关重要。

在搜索引擎早期,Google 主要索引静态 HTML 内容。由 JavaScript 生成的内容在很大程度上对搜索引擎不可见,因此静态 HTML 被广泛应用于 SEO 。

Google 推出了 AJAX 动态渲染,允许网站提供动态生成内容的 HTML 快照。这是一种权宜之计,需要开发者为页面创建单独的可抓取版本(针对爬虫使用服务器端渲染 SSR,针对用户采用客户端渲染 CSR)。

Google 开始使用没有头部的 Chrome 渲染页面,这是一次重要进步,然而这一早期浏览器版本在处理现在的 JavaScript 功能上仍存在局限性。

如今,Google 使用最新版本的 Chrome 进行渲染,与最新的 Web 技术保持同步。关键功能有:

今天,Google 的索引过程看起来是这样的:

先简单说下研究方法,我们分析了 2024 年 4 月期间从多个网站收集的数据,研究了 Googlebot 如何渲染网站。

通过特殊工具跟踪爬虫行为,我们确认了哪些页面被成功渲染、渲染所需时间,以及不同内容的处理方法。本次研究涉及 37,000 多个页面,为验证相关说法提供了可靠的数据支持。

这一误解让许多开发者避免使用 JavaScript 框架,或者采用复杂的解决方案来适配 SEO。

为验证 Google 渲染 JavaScript 内容的能力,我们重点测试了以下方面:

我们发现,在分析超过 10 万次 Googlebot 抓取后(排除错误和不可索引页面),所有 HTML 页面均被成功完整渲染,包括具有复杂 JavaScript 交互的页面。

我们通过以下方法测试了 Google 是否会对 JavaScript 密集型页面进行不同处理:

一些人认为 JavaScript 密集型页面由于渲染队列的存在会导致索引延迟。为验证这一点,我们研究了 Google 渲染页面的时间延迟和模式。

另外发现 URL 参数和更新频率也会影响渲染速度:

| URL 类型 | 第50%位 | 第75%位 | 第90%位 |

| 所有URL | 10秒 | 26秒 | 约3小时 |

| 无参数的URL | 10秒 | 22秒 | 约2.5小时 |

| 有参数的URL | 13秒 | 31秒 | 约8.5小时 |

有人认为 JavaScript 为主的网站会让 Google 更慢发现页面,我们的研究对此提出了新见解。

sitemap.xml 能大大缩短不同渲染方式之间的页面发现时间差异。本次研究揭示了 Google 对大量使用 JavaScript 网站的处理方式,打破了一些常见误解,并提供了以下关键结论和建议:

<a href="...">),而非 JS 导航。<lastmod> 标签提示 Google 最新内容。| 功能 | 静态站点生成 (SSG) | 增量静态生成 (ISR) | 服务器端渲染 (SSR) | 客户端渲染 (CSR) |

| 抓取效率:Google 能多快、多高效地访问、渲染并获取网页内容。 | 优秀 | 优秀 | 很好 | 较差 |

| 页面发现:Google 查找新 URL 进行抓取的能力。 | 优秀 | 优秀 | 优秀 | 一般 |

| 渲染完整性:Google 加载和处理网页的准确性和完整性,是否无错误。 | 稳定 | 稳定 | 稳定 | 可能失败 |

| 渲染时间:Google 完成网页渲染和处理所需的时间长短。 | 优秀 | 优秀 | 优秀 | 较差 |

| 链接结构评估:Google 如何评估网页中的链接以理解网站架构和页面的重要性。 | 渲染后评估 | 渲染后评估 | 渲染后评估 | 渲染失败可能丢失链接 |

| 内容索引:Google 将网站内容存储和组织到搜索索引中的能力。 | 稳定 | 稳定 | 稳定 | 渲染失败可能无法索引 |

尽管渲染方式可能存在细微差异,但无论使用哪种策略,Google 都会快速发现和索引你的网站。与其过度担心 Google 的渲染过程,不如专注于提升网页性能,为用户提供更好的体验。

页面速度仍是一个排名因素,Google 会通过核心网页指标 (Core Web Vitals) 评估网站性能。同时,加载速度更快也能提升用户体验,每节省 100 毫秒的加载时间,网站转化率可能提升 8%。更少的用户跳出页面,也会让 Google 认为页面更相关。性能影响叠加,毫秒决定成败。

本文是 MERJ 和 Vercel 研究实际数据总结了目前主流 AI 爬虫的几个特征。

注:Vercel 是 Next.js 的前端云平台;MERJ 是数据驱动的营销公司;本文翻译自 Vercel 的 Blog 文章《The rise of the AI crawler》。

整体上,AI 爬虫已经成为网络上的重要存在。在过去一个月中,OpenAI 的 GPTBot 在 Vercel 网络上产生了 5.69 亿次抓取,而 Anthropic 的 Claude 紧随其后,达到了 3.7 亿次。

而这 2 个加起来的请求量只占同期 Googlebot 45 亿次抓取的 20%。

Vercel 网络上的 AI 爬虫流量非常大。在过去的一个月:

GPTBot、Claude、AppleBot 和 PerplexityBot 合计抓取了近 13 亿次,约占 Googlebot 总抓取量的 28%+。

虽然 AI 爬虫尚未达到 Googlebot 的规模,但他们已占据网络爬虫流量的很大部分。

这些 AI 爬虫都在美国数据中心:

相比之下,传统搜索引擎通常会将抓取分散到多个地区。例如,Googlebot 在美国七个不同的地区运营,包括达尔斯(俄勒冈州)、康瑟尔布拉夫斯(爱荷华州)和蒙克斯科纳(南卡罗来纳州)。

AI 爬虫在 JavaScript 渲染能力方面存在明显差异。为了验证我们的发现,我们分析了使用不同技术栈的 Next.js 应用程序和传统网页应用。

调查结果一致表明,目前主要的 AI 爬虫都不渲染 JavaScript。这包括:

研究结果还显示:

数据表明,虽然 ChatGPT 和 Claude 的爬虫确实会获取 JavaScript 文件(ChatGPT:11.50%,Claude:23.84% 的请求),但它们并不执行这些文件。它们无法读取客户端渲染的内容。

但请注意,包含在初始 HTML 响应中的内容(如 JSON 数据或延迟的 React Server Components)可能仍会被索引,因为 AI 模型可以解析非HTML内容。

相比之下,Gemini 使用 Google 的基础设施,使其具有与我们在 Googlebot 分析中记录的相同渲染能力,能够完整处理最新的网页应用。

AI 爬虫在抓取 nextjs.org 时表现出明显的内容类型偏好。最明显的特征有:

作为对比,Googlebot 的抓取量(包括 Gemini 和搜索)分布更加均匀:

这些模式表明 AI 爬虫会收集多样化的内容类型——HTML、图片,甚至将 JavaScript 文件作为文本收集——这可能是为了训练他们的模型以适应各种形式的网页内容。

虽然像 Google 这样的传统搜索引擎已经针对搜索索引优化了他们的抓取模式,但较新的 AI 公司可能仍在完善他们的内容优先级策略。

我们的数据显示 AI 爬虫行为存在明显的低效现象:

对 404 错误的分析显示,除去 robots.txt 之外,这些爬虫经常尝试获取 /static/ 文件夹中的过期资源。这表明 AI 爬虫需要改进 URL 选择和处理策略以避免不必要的抓取。

这些高比例的 404 错误和重定向与 Googlebot 形成鲜明对比 – Googlebot 仅有 8.22% 的请求遇到 404 错误,1.49% 的请求遇到重定向。这表明 Google 在优化其爬虫以抓取真实资源方面确实有更多经验。

我们对流量模式的分析揭示了爬虫行为和网站流量之间存在关联性。基于来自 nextjs.org 的数据:

虽然传统搜索引擎已经开发出复杂的优先级算法,但 AI 爬虫似乎仍在不断发展其网络内容发现方法。

robots.txt 来控制爬虫访问。 robots.txt 文件对所有爬虫都有效。通过指定AI爬虫的用户代理(user agent)或产品标识(product token)来设置具体规则,以限制对敏感或非必要内容的访问。要找到需要禁止的用户代理,您需要查看每个公司自己的文档(例如,Applebot和OpenAI的爬虫)。有趣的是,即使在向Claude或ChatGPT请求最新的Next.js文档数据时,我们通常在 nextjs.org 的服务器日志中也看不到即时的获取请求。这表明AI模型可能依赖于缓存数据或训练数据,即使它们声称已获取最新信息。

我们的分析显示,AI 爬虫已经迅速成为网络上的重要存在,在 Vercel 的网络上每月有近 10 亿次请求。

然而,在渲染能力、内容优先级和效率方面,它们的行为与传统搜索引擎有明显不同。遵循已建立的网络开发最佳实践——特别是在内容可访问性方面——仍然至关重要。

如题,Google 昨晚发布了 12 月的网络垃圾更新(the December 2024 spam update)。该更新适用于全球和所有语言,可能需要长达 1 周的时间才能完成发布。

关于网络垃圾更新,Google 是这么描述:

虽然用于检测搜索结果网络垃圾的 Google 自动化系统一直在运行,但我们偶尔也会对其运作方式做出重大改进。我们将此类改进称为“网络垃圾更新”,并会在我们的 Google 搜索排名更新列表中分享相关改进。

网络垃圾更新发布后,如果发现网站的表现有变化,请查看我们的网络垃圾政策,确保网站符合相关要求。违反我们政策的网站可能会在搜索结果中排名较低,或者完全不会显示在搜索结果中。 做出更改可能会有助于改进网站的表现,前提是我们的自动化系统在几个月内发现网站符合我们的网络垃圾政策的相关要求。

对于垃圾链接更新(专门处理垃圾链接的更新),进行更改可能不会带来改进。这是因为,当我们的系统消除垃圾链接可能带来的作用后,这些链接之前可能给您的网站带来的排名优势将会丢失。这些链接可能带来的任何排名优势无法恢复。

所以,垃圾链接更新主要是针对一些违反Google指南的行为,比如关键词堆砌、滥用过期域名、垃圾链接等。

我比较关注的是,是否会对 AI 批量产生的内容产生影响。

12月核心更新在 12 日发布,在 18 日发布完成。从数据来看,此次更新的影响很明显,也有朋友反馈网站流量下降了 5~10%。

以下是几个 SEO 工具监控的排名波动情况:

你的网站近期有受到算法影响吗,请留言分享沟通~

以下是几个参考链接:

* Google 在 X 的宣布信息:https://x.com/googlesearchc/status/1869790407934259685

* 《适用于 Google 网页搜索的垃圾内容政策》https://developers.google.com/search/docs/essentials/spam-policies?hl=zh-cn